ChatGPT pode substituir o seu médico? Especialistas explicam os riscos de se consultar com IA

Ferramentas de inteligência artificial podem confundir sintomas, atrasar atendimento e induzir automedicação, dizem médico e pesquisador

Cada vez mais pessoas recorrem a inteligências artificiais (IAs) como o ChatGPT para entender sintomas, buscar diagnósticos ou decidir se precisam procurar um médico. A prática, embora rápida e acessível, pode induzir ao erro, gerar pânico e comprometer tratamentos, segundo especialistas.

Para o médico vascular Vinicius Lain, do Conselho Regional de Medicina do Rio Grande do Sul (Cremers), esse comportamento já é uma rotina nos consultórios.

— Hoje, é muito frequente o paciente chegar para o atendimento e dizer que fez uma pesquisa, que já sabe o que tem e que inclusive sabe o que precisa tomar — afirma ele.

O conselheiro do Cremers alerta que, além de interferir na escuta clínica, esse hábito pode atrasar diagnósticos e comprometer o tratamento adequado.

— Muitas vezes, ele acaba não procurando o atendimento correto no tempo certo. E, quando chega, está em uma situação mais complexa, às vezes agravada por condutas que não foram orientadas por um profissional — relata.

Quais os riscos para o atendimento médico?

— O paciente joga em uma plataforma de inteligência artificial, recebe um diagnóstico e um suposto tratamento, e a partir dali segue o que achou que estava certo — afirma Lain.

Isso pode levar à automedicação — incluindo o uso indevido de remédios — e ao atraso no início de tratamentos necessários. Segundo o médico, a falsa segurança oferecida pelas ferramentas pode acabar postergando a busca por atendimento profissional.

Muitos ainda chegam à consulta ansiosos ou pressionando por exames, com base nas informações distorcidas.

— A maioria das vezes o paciente se assusta, vem com o pior prognóstico possível depois que pesquisou. E aí, vira uma urgência para marcar a consulta, o que acaba atrapalhando o acesso ao sistema de saúde. É positivo que se tenha acesso, mas acho que a informação precisa ser filtrada por um profissional de saúde — relata.

Como o ChatGPT cria respostas para dúvidas médicas?

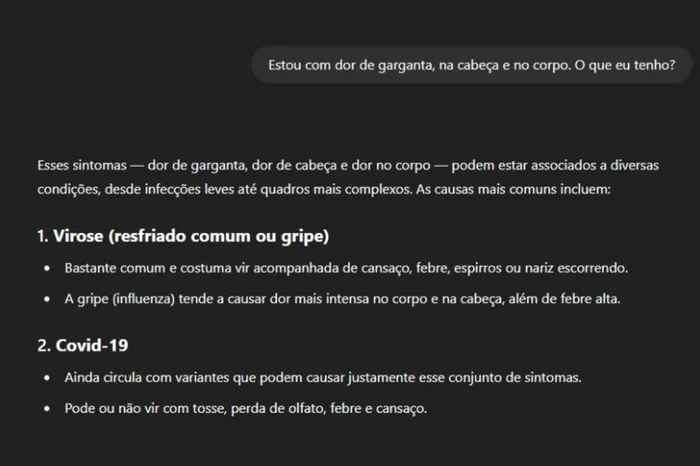

Exemplo de "atendimento" no ChatGPT.ChatGPT / Reprodução

Apesar da linguagem técnica e da confiança no tom empregado ao responder, o ChatGPT nem sempre compreende a complexidade dos sintomas ou interpreta exames equadros clínicos.

Os sistemas são treinados com grandes volumes de dados, incluindo conteúdos sobre saúde, artigos públicos e fóruns. Porém, a ferramenta organiza palavras com base em padrões de textos da internet — ela tende a prever o que tem mais chance de vir a seguir em uma frase, sem entender exatamente o que está sendo dito.

— Quando alguém pergunta, o modelo interpreta a linguagem natural, identificando termos médicos e formulando uma resposta com base nos padrões aprendidos. É uma técnica chamada tokenização, que divide a frase em partes menores (tokens), e outra chamada embedding, que tenta entender o significado desses termos no contexto — explica Rodrigo Rios, professor da CESA.R School, mestre em design de artefatos digitais e doutorando em engenharia de software.

Na prática, isso significa que o sistema pode montar uma resposta com aparência médica — mas que pode estar descontextualizada ou incorreta para aquele caso específico. No entanto, o especialista ressalta que os modelos já são projetados para deixarem os usuários cientes que não substituem médicos e evitar conselhos "perigosos".

O que são "alucinações" de IA — e por que preocupam

No contexto da inteligência artificial, o termo "alucinação" é usado quando a IA apresenta informações falsas ou imprecisas como se fossem verdadeiras. A ferramenta pode mencionar doenças que não se aplicam ao caso, citar estudos inexistentes ou indicar condutas ultrapassadas.

Segundo Rios, isso acontece porque o modelo busca completar uma sequência textual, mesmo que não exista fundamento.

— Isso pode ocorrer com nomes de doenças, tratamentos, dados estatísticos e referências científicas que nunca existiram. Mesmo com avanço nos modelos de IA, nenhuma delas está completamente livre desse problema, por isso o uso exige responsabilidade — afirma.

Existem modelos que já são pensados para o uso na medicina. É o caso do Med-PaLM, desenvolvido pela Google, treinado com dados médicos validados por especialistas, com foco em precisão, segurança e capacidade de lidar com linguagem clínica.

Mesmo assim, segundo a Organização Mundial da Saúde (OMS), o uso dessas tecnologias em saúde deve ser sempre supervisionado por profissionais qualificados.

O que diz a regulação médica sobre o uso de IA?

Em maio de 2025, o Cremers publicou uma resolução sobre o uso ético e responsável da inteligência artificial na prática médica. A norma, inédita no Brasil, define que a IA pode ser utilizada como ferramenta de apoio, desde que com conhecimento e supervisão do profissional.

— A IA pode ser útil no apoio à documentação, à organização do raciocínio clínico ou até na checagem de informações. Mas ela nunca pode ser autônoma, não substitui a decisão do médico — afirma Lain.

A resolução também estabelece que o paciente deve ser informado sobre o uso da tecnologia e qualquer informação gerada deve ter validação de um médico responsável.

— Da mesma maneira que fazemos termos de consentimento pré-operatório, ou pré-tratamento, devemos fazer também antes do uso de IA no atendimento — explica.

A IA pode ser usada com segurança?

Tanto Rios quanto Lain concordam que a IA pode ter função complementar no processo de atendimento e cuidado ao paciente, desde que usada com limites claros:

— Melhorar a consulta, organizar dados e liberar o médico para olhar no olho do paciente. Mas jamais deve ser usada para substituir a relação médica — acrescenta Lain.

Segundo os especialistas, ela pode ajudar, por exemplo:

- Esclarecer termos médicos após a consulta

- Estruturar dúvidas antes de falar com o profissional

- Organizar informações pessoais de saúde, desde que não substitua o parecer médico

Mas não deve ser usada para:

- Diagnosticar doenças com base em sintomas genéricos

- Sugerir tratamentos ou prescrever medicamentos

- Substituir a consulta presencial com um profissional

Para além das consultas, Lain enxerga um papel estratégico da inteligência artificial no futuro da saúde pública — principalmente no uso inteligente de recursos e no combate ao desperdício.

— A grande oportunidade dessas tecnologias na saúde está na redução de desperdícios. Não é só sobre atender mais rápido, mas sobre conectar o paciente certo ao médico certo, no tempo certo — conclui.

Fonte: Gaúcha ZH

Foto: Rokas / stock.adobe.com

Outras notícias

-

receitas controladas impressas entra em vigor

Elas poderão ser impressas em gráficas pelos profissionais de saúde A partir desta sexta-feira (13), todos os receituários para prescrição de medicamentos controlados podem ser impressos em gráficas pelos pr& ...

Saiba Mais -

Conab projeta safra de 354,4 milhões de toneladas no Brasil e de 40,7 milhões de toneladas no RS

O Brasil deve colher 354,4 milhões de toneladas de grãos na safra 2025/26, conforme o 3º levantamento divulgado nesta quinta-feira (11) pela Companhia Nacional de Abastecimento (Conab). O volume representa alta de 0,6% em relação ao ...

Saiba Mais